티스토리 뷰

안녕하세요, AI 엔지니어링을 학습하기 위해 인프런 AI 엔지니어링 완독챌린지에 참여하며 주차별 이해한 내용을 기록합니다.

2주차 독후감

이번 학습을 통해 AI 엔지니어링의 핵심인 평가 방법론을 깊이 이해할 수 있었습니다. 파운데이션 모델의 퍼플렉시티와 교차 엔트로피 같은 기본 지표부터 모델 출력을 참조 데이터와 비교하는 BLEU/ROUGE 지표까지 폭넓게 익혔습니다.

특히, 인간 평가의 한계를 극복하기 위한 AI 평가자(LLM Evaluator)의 도입과 그 한계를 명확히 인식한 점이 인상 깊었습니다. 또한, 실제 AI 시스템을 배포하기 위해 도메인 특화 능력, 생성 능력, 비용, 지연 시간 등을 종합적으로 고려하는 평가 파이프라인 설계의 중요성을 깨달았습니다.

AI 시스템을 성공적으로 구축하기 위해서는 단순한 성능 지표를 넘어선 포괄적이고 체계적인 평가 전략이 필수적이라는 결론을 얻었습니다.

[월] 3장. 평가 방법론 - 파운데이션 모델 평가의 어려움 ~ 정확한 평가(p.152 ~ p.176)

3.1 파운데이션 모델 평가의 어려움

파운데이션 모델(Foundation Models, FMs)은 그 범용성과 규모 때문에 평가가 전통적인 AI 모델보다 훨씬 복잡합니다.

- 다양한 작업: 단일 작업이 아닌 수많은 다운스트림 작업에 적용되므로, 포괄적인 평가 기준을 설정하기 어렵습니다.

- 블랙박스 특성: 모델 내부 작동 방식을 완전히 이해하기 어렵습니다.

- 새로운 능력 출현: 규모가 커지면서 예상치 못한 **창발적 능력(Emergent Abilities)**이 나타나, 이를 평가하기 위한 새로운 방법론이 필요합니다.

- 평가 데이터의 오염: 학습 데이터에 평가 벤치마크 데이터가 포함되었을 가능성(데이터 오염)이 있어, 진정한 일반화 능력을 측정하기 어렵습니다.

3.2 언어 모델링 지표 이해하기

언어 모델(Language Model, LM)의 기본적인 성능을 측정하는 지표들입니다.

3.2.1 엔트로피 (Entropy, $H$)

- 정의: 정보 이론에서 불확실성의 정도를 나타냅니다. 확률 분포의 예측 난이도라고도 볼 수 있습니다.

- 수식:

- 해석: 엔트로피 값이 높을수록 예측이 어렵고 불확실성이 크다는 의미입니다.

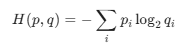

3.2.2 교차 엔트로피 (Cross-Entropy, $H(p, q)$)

- 정의: 모델이 예측한 확률 분포($q$)와 실제(정답) 확률 분포($p$)의 차이를 측정하는 지표입니다. 언어 모델 학습 시 **손실 함수(Loss Function)**로 주로 사용됩니다.

- 수식:

- 해석: 교차 엔트로피 값이 낮을수록 모델의 예측이 정답에 가깝다는 뜻입니다.

3.2.3 문자당 비트 (Bits Per Character, BPC)와 바이트당 비트 (Bits Per Byte, BPB)

- 정의: 텍스트 압축 관점에서, 텍스트의 한 문자(Character) 또는 **바이트(Byte)**를 인코딩하는 데 평균적으로 필요한 비트 수를 나타냅니다.

- 관계: BPC와 BPB는 교차 엔트로피와 밀접하게 관련되어 있으며, 값이 낮을수록 모델이 텍스트를 더 잘 예측하고 있다는 의미입니다.

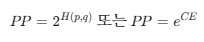

3.2.4 퍼플렉시티 (Perplexity, PP)

- 정의: 언어 모델이 다음에 올 단어를 얼마나 **"혼란스러워하는지"**를 나타내는 지표입니다. 교차 엔트로피의 지수 함수 값입니다.

- 수식: (여기서 $CE$는 자연로그를 사용한 교차 엔트로피)

- 해석: 퍼플렉시티 값이 낮을수록 모델의 성능이 좋다는 의미입니다. 예측의 불확실성 정도를 직관적인 수로 보여줍니다.

3.2.5 퍼플렉시티 해석과 활용 사례

- 퍼플렉시티 100은 모델이 다음에 올 단어를 평균적으로 100개의 단어 중 하나로 예측하고 있다는 뜻으로 해석할 수 있습니다.

- 활용: 모델 간의 기본 성능 비교, 학습 과정에서의 수렴 정도 확인, 이상 징후 감지 등에 사용됩니다.

3.3 정확한 평가

3.3.1 기능적 정확성 (Functional Correctness)

- 정의: 모델의 출력이 특정 사실이나 논리적 요구사항에 얼마나 정확하게 부합하는지를 평가합니다. 단순히 언어의 유창성을 넘어, 실질적인 정답을 맞추는 능력을 측정합니다.

- 예시: 질문-답변(QA) 작업에서 정답을 맞히는 비율.

3.3.2 참조 데이터 유사도 측정

모델이 생성한 텍스트가 사람이 작성한 **정답(참조 데이터)**과 얼마나 비슷한지를 측정합니다.

- BLEU (Bilingual Evaluation Understudy): 기계 번역에서 주로 사용되며, 모델 출력과 참조 번역 간에 n-gram이 얼마나 겹치는지를 기반으로 점수를 매깁니다.

- ROUGE (Recall-Oriented Understudy for Gisting Evaluation): 주로 요약에서 사용되며, 모델 출력에서 참조 요약의 n-gram이 얼마나 많이 회수되었는지를 측정합니다.

- METEOR (Metric for Evaluation of Translation with Explicit Ordering): 단어의 동의어, 어근 일치, 단어 순서 등을 고려하여 BLEU의 한계를 개선한 지표입니다.

3.3.3 임베딩 소개

- 정의: 단어나 문장 같은 텍스트 데이터를 다차원 벡터 공간의 숫자로 변환하는 기술입니다.

- 특징: 의미적으로 유사한 단어들은 벡터 공간에서 가까운 위치에 존재하게 됩니다.

- 활용: 임베딩을 이용해 모델 출력을 정답 임베딩과 비교하는 임베딩 기반 유사도 측정이 가능하며, 이는 전통적인 n-gram 기반 지표보다 의미적 유사성을 더 잘 포착할 수 있습니다.

[화] AI 평가자 ~ 비교 평가를 통해 모델 순위 정하기(p.177 ~ p.198)

3.4 AI 평가자 (AI Evaluator)

AI, 특히 대규모 언어 모델(LLM)을 활용하여 다른 AI 모델의 출력을 평가하는 방법입니다.

3.4.1 AI 평가자를 쓰는 이유

- 휴먼 평가의 한계: 사람이 직접 평가하는 것은 비용이 많이 들고, 시간이 오래 걸리며, 평가자 간의 일관성(편향) 문제가 발생할 수 있습니다.

- 세밀한 평가 가능: LLM은 단순한 정답 여부를 넘어 유창성, 일관성, 유용성 등 복잡하고 주관적인 품질까지 평가할 수 있습니다.

- 확장성: 대규모 데이터에 대해 빠르고 일관된 평가를 수행할 수 있습니다.

3.4.2 AI 평가자 사용법

- 프롬프트 엔지니어링: 평가 기준과 척도, 그리고 평가 대상 모델의 출력과 정답(또는 입력)을 정확하게 포함하는 프롬프트를 설계합니다.

- 출력 형식 지정: 평가 점수, 이유, 등급 등을 **구조화된 형식(예: JSON)**으로 출력하도록 지시하여 후처리 및 분석을 용이하게 합니다.

- 예시 제공: 평가자가 이해하기 쉽도록 좋은 평가와 나쁜 평가의 예시를 제공하는 것이 효과적입니다(Few-shot Learning).

3.4.3 AI 평가자의 한계

- 환각(Hallucination): 평가자 LLM이 실제로는 틀린 정보를 '정답'으로 착각하고 높은 점수를 줄 수 있습니다.

- 바이어스(Bias): 평가자 LLM이 특정 모델이나 스타일(예: 장황함)에 편향되어 일관성 없는 결과를 낼 수 있습니다.

- 비용 및 지연 시간: 평가 자체에 LLM을 사용하므로 API 사용 비용과 시간이 추가됩니다.

3.4.4 평가자로 활용 가능한 모델

- GPT-4, Claude 3 등 성능이 우수한 상업용(Closed-source) LLM이 주로 높은 평가 일관성을 보입니다.

- 개방형(Open-source) LLM 중에서도 평가 작업에 특화되어 파인튜닝된 모델들이 활용되기도 합니다. 일반적으로 평가자는 평가 대상 모델보다 더 높은 성능을 가진 모델을 사용하는 것이 권장됩니다.

3.5 비교 평가를 통해 모델 순위 정하기

두 개 이상의 모델 출력을 나란히 놓고 비교하여 어떤 모델이 더 우수한지 판단하는 방법입니다.

3.5.1 비교 평가의 과제들

- 순서 편향(Order Bias): 사람 또는 AI 평가자가 먼저 제시된 모델의 출력을 더 좋게 평가하는 경향이 있습니다.

- 해결책: 출력 순서를 무작위로 섞습니다(Randomization).

- 위치 편향(Position Bias): 단순히 특정 위치(예: 왼쪽)에 있는 항목을 선호하는 경향이 있습니다.

- 평가 기준의 모호성: 명확하고 구체적인 평가 기준 없이는 평가자마다 주관적인 판단을 내릴 수 있습니다.

3.5.2 비교 평가의 미래

- 자동화 및 표준화: AI 평가자를 활용하여 비교 평가의 속도와 확장성을 높이고, 평가 기준을 표준화하려는 노력이 진행 중입니다.

- Elo Rating 시스템: 체스 랭킹 시스템처럼, 모델 간의 승패 기록을 기반으로 상대적인 성능 순위를 매기는 방식이 활용됩니다(예: Chatbot Arena).

- 인간 개입 최소화: 장기적으로는 인간의 주관적 판단에 덜 의존하고, 실제 사용자 피드백과 실시간 상호작용을 반영하는 평가 시스템이 중요해질 것입니다.

[수] 4장. AI 시스템 평가하기 - 평가 기준(p.199 ~ p.220)

4.1 평가 기준

AI 시스템을 실제 환경에 배포하기 전에 고려해야 할 포괄적인 평가 기준들입니다.

4.1.1 도메인 특화 능력 (Domain-Specific Capability)

- 정의: 모델이 특정 산업, 분야, 업무에 필요한 전문 지식을 얼마나 정확하게 이해하고 적용할 수 있는지에 대한 능력입니다.

- 예시: 법률 도메인 모델의 경우, 법률 조항을 정확히 해석하고 적용하는 능력.

- 평가: 해당 도메인의 전문가가 설계한 벤치마크 데이터셋이나 테스트 케이스를 사용해야 합니다.

4.1.2 생성 능력 (Generative Capability)

- 정의: 모델이 일관성, 유창성, 창의성, 스타일을 유지하며 품질 좋은 텍스트(또는 이미지, 코드)를 생성할 수 있는 능력입니다.

- 평가 지표:

- 일관성(Coherence): 생성된 텍스트가 전체적인 맥락에 논리적으로 부합하는가.

- 유창성(Fluency): 문법적 오류 없이 자연스러운가.

- 사실 충실도(Fidelity): 제공된 입력(소스 문서 등)에 사실적으로 기반하는가.

- 창의성(Creativity): 참신하고 독창적인 아이디어를 제시하는가.

4.1.3 지시 수행 능력 (Instruction Following Capability)

- 정의: 사용자의 **지시(프롬프트)**를 정확하게 이해하고, 그 지시에 따라 원하는 출력 형식과 내용을 생성할 수 있는 능력입니다.

- 중요성: RAG 시스템이나 에이전트와 같이 복잡한 시스템의 구성 요소로 LLM을 사용할 때 매우 중요합니다.

- 평가: 지시의 복잡성, 길이, 제약 조건 등을 다양하게 바꿔가며 테스트해야 합니다.

4.1.4 비용과 지연 시간 (Cost and Latency)

- 비용 (Cost): 모델을 운영하고 API를 사용할 때 발생하는 재정적 비용입니다. 특히 상용 모델(API)을 사용할 경우 토큰당/호출당 비용을 고려해야 합니다.

- 지연 시간 (Latency): 사용자가 요청을 보낸 후 모델이 응답을 반환하는 데 걸리는 시간입니다. 실시간 서비스(예: 챗봇)에서는 사용자 경험에 직결되므로 중요합니다.

- 평가: 처리량(Throughput), GPU/CPU 사용량, API 호출 비용 등을 종합적으로 고려하여 성능 대비 효율성을 측정해야 합니다.

[목] 모델 선택 ~ 평가 파이프라인 설계하기(p.221 ~ p.256)

4.2 모델 선택

4.2.1 모델 선택 과정

- 요구 사항 정의: 해결하려는 문제와 필요한 AI 시스템의 **기능적/비기능적 요구 사항(비용, 지연 시간)**을 명확히 합니다.

- 후보 모델 탐색: 공개 벤치마크, 논문, 커뮤니티 등을 통해 요구 사항에 부합하는 후보 모델 목록을 작성합니다.

- 예비 평가 (POC): 소규모 데이터셋으로 후보 모델들의 핵심 성능을 빠르게 테스트합니다.

- 심층 평가: 최종 후보 모델들을 실제 환경과 유사한 평가 파이프라인을 통해 상세하게 비교 분석합니다.

4.2.2 모델 자체 개발 대 상용 모델 구매

| 구분 | 모델 자체 개발 (Build) | 상용 모델 구매 (Buy) |

| 장점 | 요구사항에 최적화 가능, 데이터 보안 용이, 비용 통제 가능 (장기적) | 빠른 배포 및 사용 가능, 최첨단 성능 즉시 활용, 유지 보수 부담 적음 |

| 단점 | 높은 초기 비용, 긴 개발 시간, 전문 인력 필요, 성능 격차 발생 가능 | API 비용 발생 (장기적 비용 증가), 데이터 유출/보안 문제, 커스터마이징 한계 |

| 고려 사항 | 핵심 경쟁력과 자원을 고려하여 전략적으로 선택합니다. | 비용, API 안정성, 데이터 정책 등을 면밀히 검토해야 합니다. |

4.2.3 공개 벤치마크 탐색하기

- 정의: 학계나 산업계에서 모델의 성능을 비교하기 위해 공개한 표준화된 데이터셋 및 평가 기준입니다.

- 예시: MMLU, HELM, GLUE, SuperGLUE 등

- 활용: 모델 선택의 초기 단계에서 후보 모델의 일반적인 능력을 파악하는 데 유용하지만, 실제 도메인 성능을 보장하지는 않으므로 참고 자료로만 활용해야 합니다.

4.3 평가 파이프라인 설계하기

AI 시스템의 품질을 지속적이고 체계적으로 관리하기 위한 자동화된 절차입니다.

4.3.1 1단계: 시스템의 모든 구성 요소 평가하기

- AI 시스템은 보통 여러 구성 요소(프롬프트, RAG, 모델, 후처리 로직 등)의 집합체입니다.

- 각 구성 요소가 제대로 작동하는지 단위 테스트(Unit Test) 방식으로 먼저 평가해야 합니다.

- 예시: RAG 시스템의 경우, 검색(Retrieval) 모듈의 정확도, 생성(Generation) 모듈의 답변 품질 등을 분리하여 평가합니다.

4.3.2 2단계: 평가 가이드라인 만들기

- 평가자들이 일관성 있게 평가할 수 있도록 명확하고 구체적인 평가 기준을 문서화합니다.

- 구성: 평가 목표, 기준 정의, 척도(Scale) 정의(예: 1~5점), 좋은/나쁜 응답 예시 등을 포함합니다.

4.3.3 3단계: 평가 방법과 데이터 정의하기

- 평가 방법 정의: 자동 평가(지표), AI 평가자, 휴먼 평가 중 적절한 조합을 선택합니다.

- 데이터 정의:

- 테스트 데이터셋을 실제 운영 환경을 반영하여 다양하고 대표성 있게 구축합니다.

- 데이터 오염을 피하기 위해 학습 데이터와 분리되어야 합니다.

- 에지 케이스(Edge Cases) 및 취약성 테스트를 위한 데이터셋을 포함합니다.

'IT > AI' 카테고리의 다른 글

| [완독 챌린지] 5주차 - AI 엔지니어링 (1) | 2025.12.14 |

|---|---|

| [완독 챌린지] 4주차 - AI 엔지니어링 (1) | 2025.12.07 |

| [완독 챌린지] 3주차 - AI 엔지니어링 (0) | 2025.11.29 |

| [완독 챌린지] 1주차 - AI 엔지니어링 (0) | 2025.11.16 |

| [AI] AI Agent를 활용한 EKS 애플리케이션 및 인프라 트러블슈팅 (0) | 2025.10.24 |

- Total

- Today

- Yesterday

- AI Engineering

- GKE

- cloud

- handson

- 혼공챌린지

- AI

- GCP

- 혼공파

- SDWAN

- 도서

- 파이썬

- EKS

- k8s cni

- CICD

- NW

- k8s

- autoscaling

- 혼공단

- ai 엔지니어링

- IaC

- operator

- S3

- AWS

- terraform

- VPN

- PYTHON

- cni

- security

- k8s calico

- NFT

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |